Metodo de Regresinon Lineal

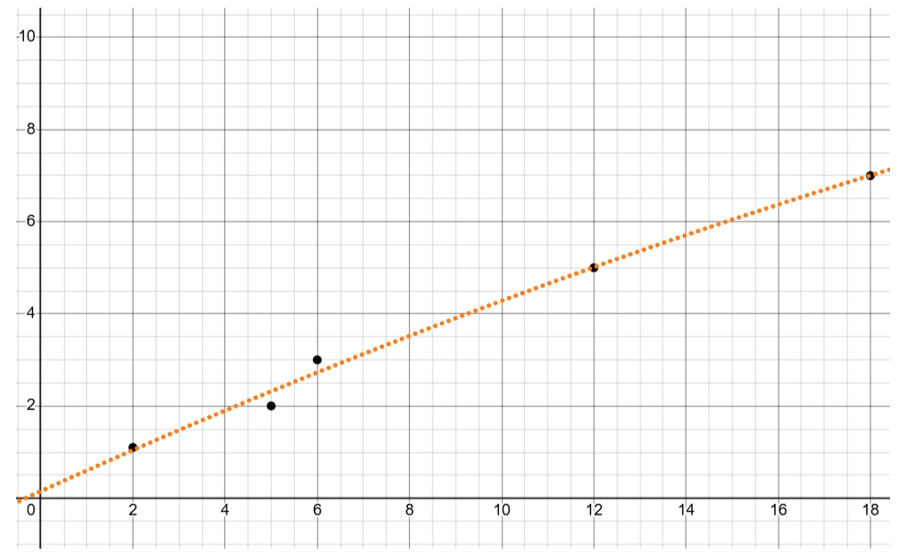

Regresión Lineal: La regresión lineal modela la relación entre una variable

dependiente \(y\) y una variable independiente \(x\). La ecuación es:

$$y = \beta_0 + \beta_1 x $$

donde:

- \(\beta_0\): Intersección, valor de \(y\) cuando \(x = 0\).

- \(\beta_1\): Pendiente, cambio promedio en \(y\) por unidad de cambio en \(x\).

Metodo de Regresion Lineal Multiple

Regresión Lineal Múltiple: Extiende la regresión lineal a múltiples variables

independientes \((x_1, x_2, \dots, x_n)\). La ecuación es:

$$y = \beta_0 + \beta_1 x_1 + \beta_2 x_2 + \dots + \beta_n x_n + $$

donde:

- \(\beta_0\): Intersección o término constante.

- \(\beta_i\): Coeficiente que mide el impacto de \(x_i\) en \(y\).

Metodo de Regresion Polinommial

Regresión Polinomial: Adapta la regresión lineal para modelar relaciones no

lineales entre \(y\) y \(x\) utilizando potencias de \(x\). La ecuación es:

$$y = \beta_0 + \beta_1 x + \beta_2 x^2 + \dots + \beta_n x^n $$

donde:

- \(x^2, x^3, \dots, x^n\): Terminos que capturan tendencias no lineales en los datos.

- \(\beta_i\): Coeficientes que determinan la forma del ajuste.

Formula de la Regresion Lineal Multiple

$$\begin{bmatrix}

n & \sum x_1 & \sum x_2 & \cdots & \sum x_k \\

\sum x_1 & \sum x_1^2 & \sum x_1 x_2 & \cdots & \sum x_1 x_k \\

\sum x_2 & \sum x_1 x_2 & \sum x_2^2 & \cdots & \sum x_2 x_k \\

\vdots & \vdots & \vdots & \ddots & \vdots \\

\sum x_k & \sum x_1 x_k & \sum x_2 x_k & \cdots & \sum x_k^2

\end{bmatrix}

\begin{bmatrix}

\beta_0 \\

\beta_1 \\

\beta_2 \\

\vdots \\

\beta_k

\end{bmatrix}

=

\begin{bmatrix}

\sum y \\

\sum x_1 y \\

\sum x_2 y \\

\vdots \\

\sum x_k y

\end{bmatrix}$$

Formula de la Regresion Polinomial

$$\begin{bmatrix}

n & \sum x & \sum x^2 & \cdots & \sum x^k \\

\sum x & \sum x^2 & \sum x^3 & \cdots & \sum x^{k+1} \\

\sum x^2 & \sum x^3 & \sum x^4 & \cdots & \sum x^{k+2} \\

\vdots & \vdots & \vdots & \ddots & \vdots \\

\sum x^k & \sum x^{k+1} & \sum x^{k+2} & \cdots & \sum x^{2k}

\end{bmatrix}

\begin{bmatrix}

\beta_0 \\

\beta_1 \\

\beta_2 \\

\vdots \\

\beta_k

\end{bmatrix}

=

\begin{bmatrix}

\sum y \\

\sum xy \\

\sum x^2 y \\

\vdots \\

\sum x^k y

\end{bmatrix}$$

Antecedentes y Relación con Otros Métodos

La regresión, como técnica estadística, tiene sus raíces en el siglo XIX, cuando Francis Galton y

Karl Pearson introdujeron el concepto para estudiar relaciones entre variables. Originalmente

utilizada para analizar patrones de herencia genética, esta herramienta evolucionó rápidamente para

abordar problemas más amplios en economía, ingeniería y ciencias sociales. Su fundamento en los

métodos de mínimos cuadrados permitió que se desarrollaran variantes como la regresión lineal

múltiple, que analiza varias variables simultáneamente, y la regresión polinomial, que modela

relaciones no lineales. Con el tiempo, se convirtió en la base para técnicas modernas de aprendizaje

automático y análisis predictivo.

Aplicaciones

Las aplicaciones de la regresión son amplias y abarcan múltiples disciplinas. En economía, se utiliza

para prever tendencias de mercado y analizar el impacto de políticas económicas. En ingeniería, es

clave para modelar sistemas físicos y realizar simulaciones. En salud, ayuda a relacionar factores

de riesgo con enfermedades, mientras que en ciencias sociales, se usa para entender patrones de

comportamiento humano. Además, la regresión polinomial es especialmente útil en ciencias naturales,

como la física, para modelar fenómenos complejos con precisión. Su versatilidad la convierte en una

herramienta indispensable para el análisis y la toma de decisiones basadas en datos.

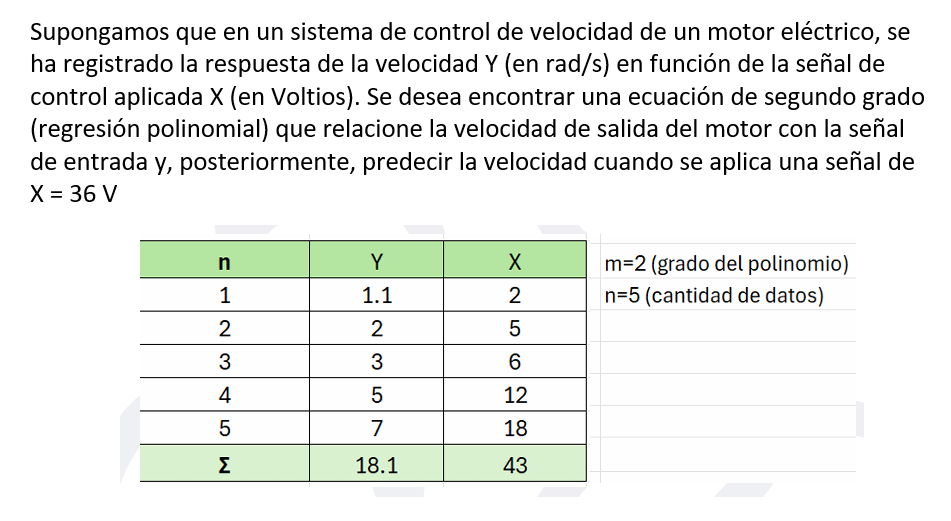

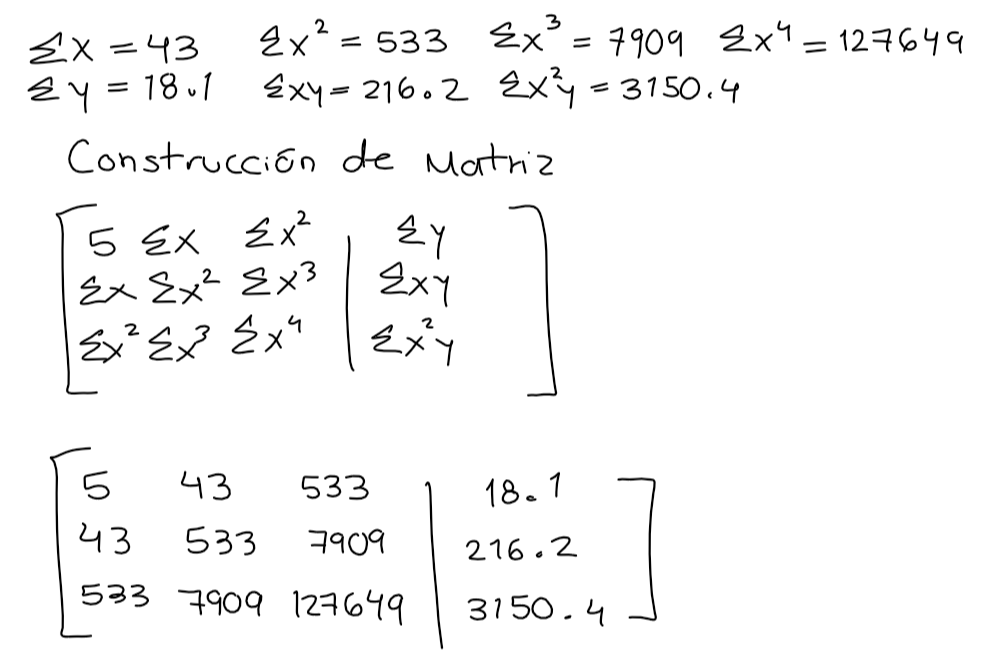

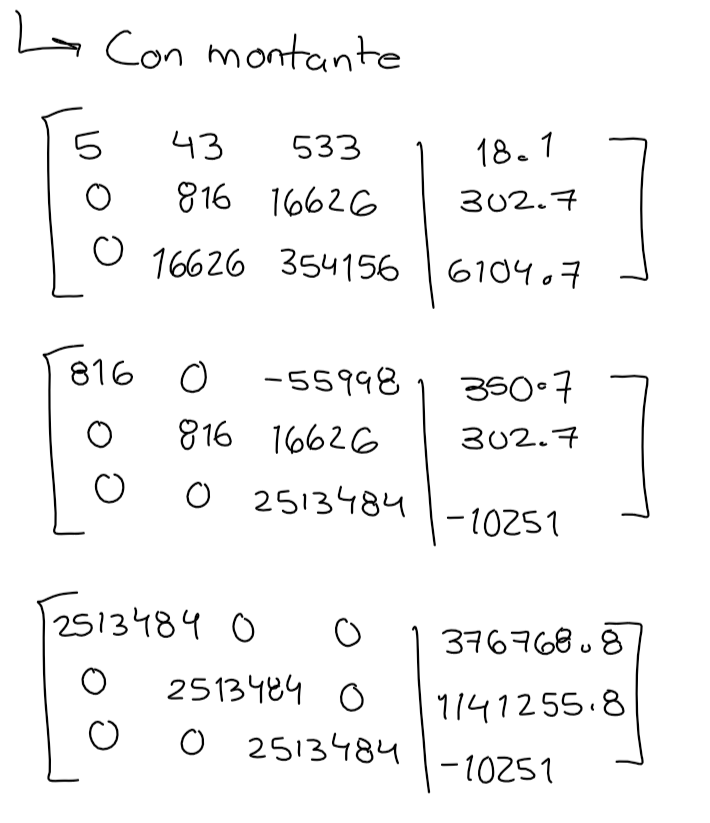

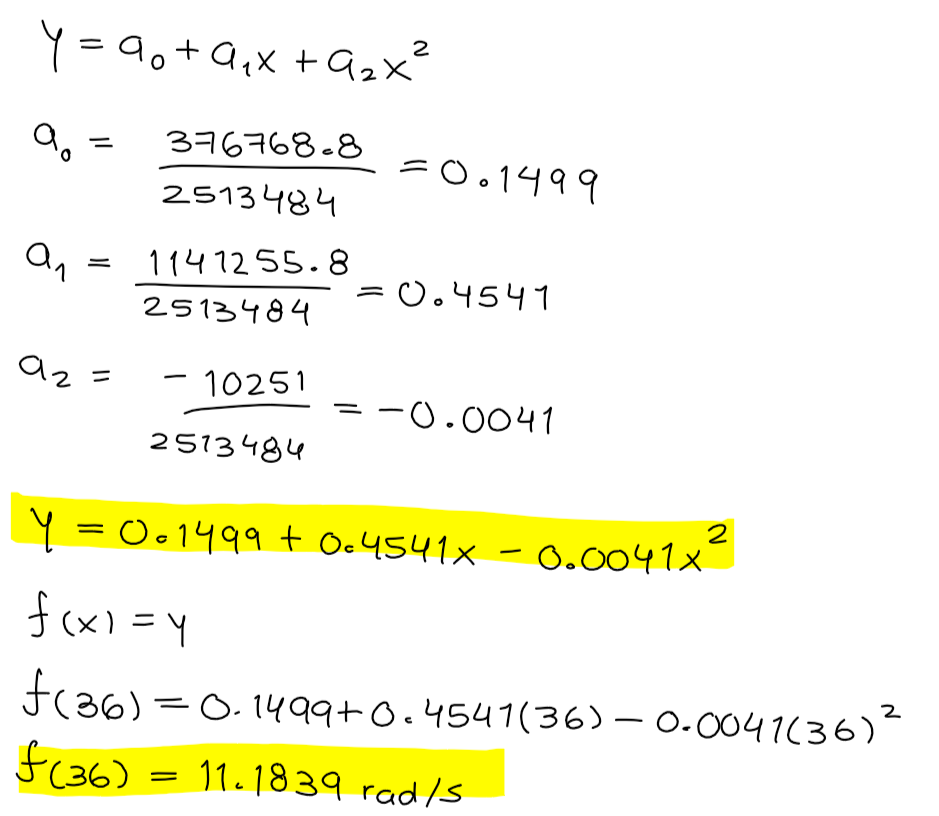

Algoritmo

Regresión Lineal Múltiple:

- Recolectar los datos de las variables independientes \((x_1, x_2, \dots, x_p)\) y la variable dependiente \(y\).

- Formar la matriz de diseño \(X\).

- Resolver el sistema de ecuaciones normal

- Formar la ecuación del modelo:

$$y = \beta_0 + \beta_1 x_1 + \beta_2 x_2 + \dots + \beta_p x_p$$

- Validar el modelo utilizando métricas como \(R^2\)

Regresión Polinomial:

- Recolectar los datos de la variable independiente \(x\) y la variable dependiente \(y\).

- Decidir el grado del polinomio (\(d\)) que se ajustará al modelo.

- Transformar los datos, incluyendo potencias de \(x\) hasta \(x^d\) como nuevas variables independientes (e.g., \(x^2, x^3, \dots, x^d\)).

- Formar la matriz de siguierndo el metodo de minimos cuadrados.

- Resolver el sistema de ecuaciones.

- Formar la ecuación del modelo:

$$y = \beta_0 + \beta_1 x + \beta_2 x^2 + \dots + \beta_d x^d$$

- Evaluar el modelo utilizando métricas de ajuste o comparando los errores residuales.